阿里云弹性计算升级:CPU上跑推理,模型建成本降低50%

编辑|邓咏仪

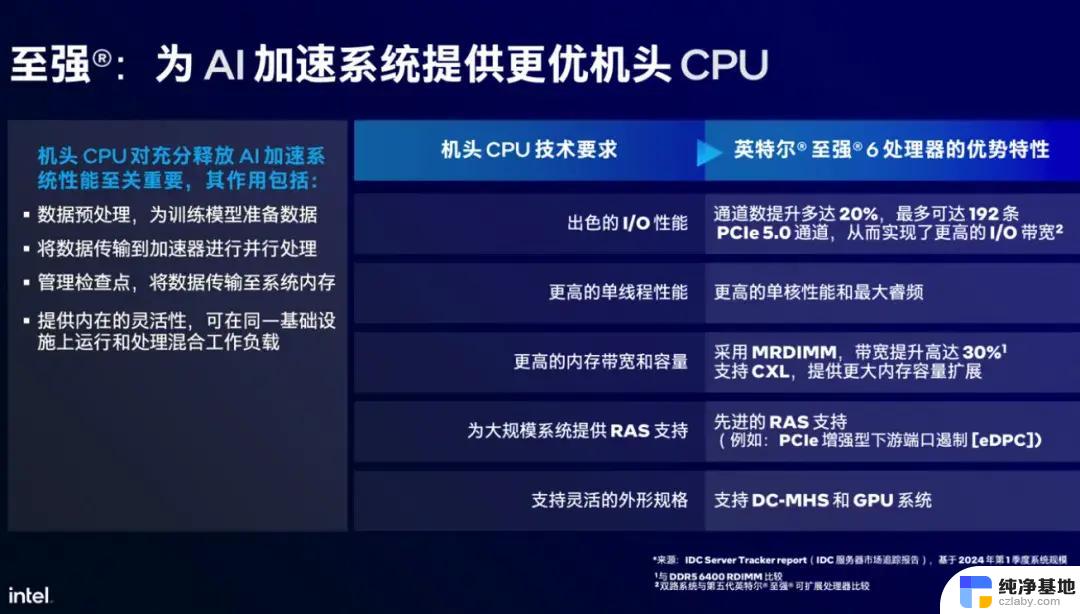

1月11日,阿里云升级第八代企业级通用计算实例ECS g8i产品。新产品依托于英特尔在2023年12月发布的第五代至强可扩展处理器,以及阿里云自研的“飞天+CIPU”架构体系所搭建。

升级之后,新产品的在算力、网络、性能、应用场景方面有能力提升:

算力层,ECS g8i实例的ECS g8i实例的L3缓存容量提升到320MB,内存速率提升至5600MT/s;性能方面,整机性能提升了85%,单核性能提升25%;网络方面,PPS达3000万,时延低至8微秒;场景上,新的ECS g8i实例可将MySQL数据库的性能提升至60%,Redis和Nginx的性能分别提升40%和24%。面对目前火热的大模型需求,新升级的ECS g8i实例进行了升级优化,让大模型跑在CPU上,并有效降低了模型搭建成本。

这对于大模型的商业化落地意味着全新的尝试。一般而言,CPU在浮点、并行维度和内存宽带上都与GPU能力相差甚远,让模型跑在CPU上是一件困难的事。

在技术,ECS g8i上做了一次新的尝试。为了解决首包延迟和吞吐性能技术难题,ECS g8i实例进行了针对性的技术优化,其内置指令集从AVX512升级到了Intel AMX高级矩阵扩展加速技术,可以加速模型运行。

有了加速能力之后,模型推理过程在CPU上也能跑通,大大降低了大模型搭建和推理成本。此外,CPU相较GPU而言,更容易获取,成本也更低,所以,这也为解决算力短缺难题打开了新可能。

阿里云弹性计算产品线总经理张献涛表示:“g8i可更迅速地响应中小规模参数模型,运行知识检索、问答系统及摘要生成等AI工作负载时。起建成本相比A10 GPU云服务器下降50%。”

阿里云新发布的ECS g8i产品

目前,在CPU上,ECS g8i不仅能支持中小模型的推理计算,还可以支撑72B参数级别的大语言模型分布式推理。以阿里云通义千问开源的Qwen-72B大模型为例,它可在g8i实例eRDMA网络构建的集群实现高效运行。输入小于500字时,首包延时小于3秒,每秒可生成7个Token。

此外,ECS g8i还能支持超过32batchsize的超大参数规模的AI模型负载,涵盖目前市面上的文生图、AI生成代码、虚拟助手以及创意辅助工具等多类模型。

在实际的模型落地中,要结合场景端的需求,综合考量效果和成本。根据阿里云的测试,通过CPU做超高并发,可以充分利用算力,进行长时间计算和推理。目前,ECS g8i在一些对实时性要求不高的离线场景,比如创意广告生成、离线视频摘要生成等AI功能方面,已经有良好的效果。

阿里云弹性计算升级:CPU上跑推理,模型建成本降低50%相关教程

-

老平台升级首选!超高性价比CPU,网游性能暴打挤牙膏家CPU

老平台升级首选!超高性价比CPU,网游性能暴打挤牙膏家CPU2024-11-10

-

双11值得推荐的性价比CPU,建议小白收藏。最新CPU性价比推荐

双11值得推荐的性价比CPU,建议小白收藏。最新CPU性价比推荐2024-10-16

-

新的 AMD Linux 补丁旨在进一步提升异构 CPU 设计的性能,加速你的计算体验

新的 AMD Linux 补丁旨在进一步提升异构 CPU 设计的性能,加速你的计算体验2024-10-04

-

量子处理器计算能力强于经典超算,革命性突破在即

量子处理器计算能力强于经典超算,革命性突破在即2024-10-10

- 10月份主流CPU行情及推荐,附购买建议!最新报价及性能评测

- 天检说法:不翼而飞的CPU——如何防止计算机处理器失踪

- AMD推出EPYC霄龙4004系列处理器:AM5平台、最高16核X3D,引领高性能计算新潮流

- 微软GraphRAG AI提效:改善数据检索,tokens成本降低77%的全面指南

- AMD平台历代性价比CPU推荐,平民玩家CPU购买指南

- 英伟达GPU芯片8年算力增长1000倍,能耗降低了350倍,创新技术助力性能飞跃

- 微软发力!暴雪首次为其他游戏打广告,大秘境难度再次下调

- 亚马逊畅销排行榜:AMD一统江湖,全球最热门的10款CPU推荐!

- 电脑的CPU 都有哪些品牌,你知道几个? - 了解电脑CPU的常见品牌

- 如何正确更新NVIDIA显卡驱动以提升性能和稳定性:详细教程

- 微软游戏业务负责人:未来还会继续推出Xbox游戏机,打造更多优秀游戏体验

- 微软发布Win11 RP 26100.2448预览版:简化日期和时间显示,提升用户体验

微软资讯推荐

- 1 微软发力!暴雪首次为其他游戏打广告,大秘境难度再次下调

- 2 电脑的CPU 都有哪些品牌,你知道几个? - 了解电脑CPU的常见品牌

- 3 如何正确更新NVIDIA显卡驱动以提升性能和稳定性:详细教程

- 4 微软游戏业务负责人:未来还会继续推出Xbox游戏机,打造更多优秀游戏体验

- 5 微软GraphRAG AI提效:改善数据检索,tokens成本降低77%的全面指南

- 6 英伟达AI大模型被曝不及预期,国产GPU能否平替?

- 7 如何查看电脑的显卡型号和性能信息?快速了解电脑显卡配置方法

- 8 微软推送Win10服务器端更新,Win11 24H2升级推荐速度快

- 9 如何正确更新NVIDIA显卡驱动以提升性能和稳定性?

- 10 台式电脑CPU天梯图2024年11月新版 桌面CPU性能排行榜:最新CPU性能排名

win10系统推荐

系统教程推荐