微软推出Copilot AI键 为Windows 11电脑带来革新的全面评估

人工智能在医疗保健领域的存在正在迅速扩大,一项调查显示。超过10%的临床医生已经在日常工作流程中使用像ChatGPT这样的聊天机器人。此外,近一半受访的临床医生表示有兴趣利用人工智能进行数据录入、排班和临床研究等任务。人工智能在为具有带有污名化的精神疾病的患者提供护理方面发挥关键作用的潜力巨大,这些患者可能对寻求心理健康问题的治疗持犹豫态度。

人工智能能够拥有对人类痛苦的同理心吗?

人工智能能够拥有对人类痛苦的同理心吗?虽然人工智能有能力在缺失数据点的情况下生成输出,但它对人类经历的同理心能力有限。而心理治疗师则接受了各种疗法模式的培训,并具备同理心这一关键技能。人工智能缺乏共同经历,如恐惧、社会不公正或喜悦,这阻碍了它与患者建立同理心的能力。此外,人工智能依赖过去的数据来预测未来的结果。可能会导致算法偏见和潜在的有害后果,就像比利时一名男子在与聊天机器人讨论生态焦虑后自杀的案例中所看到的那样。

人工智能的偏见及其在精神病学中的作用由于其算法性质,人工智能容易持续存在有害偏见,包括性别和种族偏见。在心理治疗的背景下,这些偏见尤为重要。患者通常更喜欢与自己种族和民族相同的治疗师,因为共同经历和文化理解在治疗中至关重要。然而,人工智能目前的能力无法完全满足这些偏好。虽然人工智能可以为精神病学的进展做出贡献,比如协助分析昼夜生物节律以预测重度抑郁发作,但它在临床精神病学中的角色尚未明确。我们需要谨慎行事,并认识到人工智能技术在生死关头的情况下尚不适用。

微软推出Copilot AI键 为Windows 11电脑带来革新的全面评估相关教程

-

微软推出全新Copilot键,科创板50ETF(588080)一键布局AI PC发展机会

微软推出全新Copilot键,科创板50ETF(588080)一键布局AI PC发展机会2024-01-09

-

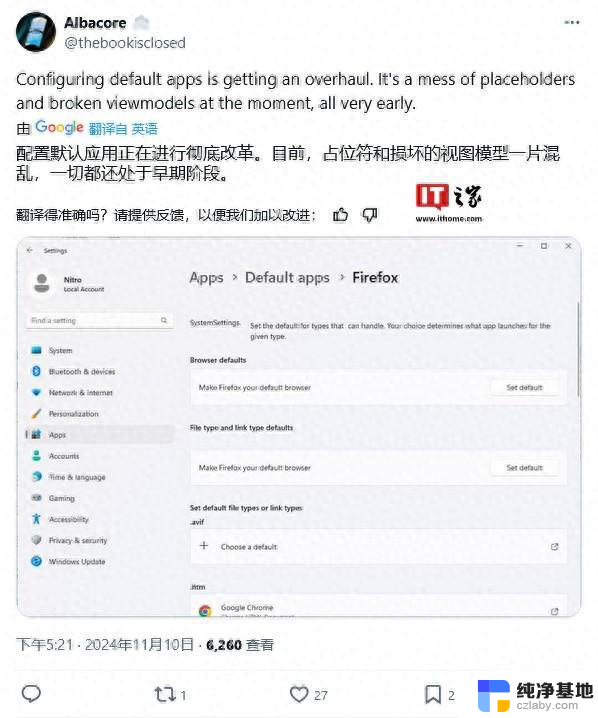

微软正重构Windows 11默认应用设置页面,全新设计带来更便捷的操作体验

微软正重构Windows 11默认应用设置页面,全新设计带来更便捷的操作体验2024-11-12

-

微软推出新型AI工具VASA-1,可将照片转化为逼真视频,让您的照片动起来

微软推出新型AI工具VASA-1,可将照片转化为逼真视频,让您的照片动起来2024-04-21

-

Windows 12来了!微软曝光系统细节:换血式升级,体验全新操作界面

Windows 12来了!微软曝光系统细节:换血式升级,体验全新操作界面2023-11-18

- 微软为何不愿意推出巅峰之作:Windows12,可能的原因揭秘

- 微软AI革新:训练成本减半,微小模型引领语言学习新纪元最新

- 微软发布2024最新Windows11免激活镜像,免费下载体验全新系统!

- 微软为何不愿意推出巅峰之作:Windows 12的原因是什么?

- 微软公司推出社交分享功能,引领科技巨头行业新潮流

- 微软加入自定义GPT大战:AI技术新纪元的序幕,掀起AI技术革新的篇章

- 微软发力!暴雪首次为其他游戏打广告,大秘境难度再次下调

- 亚马逊畅销排行榜:AMD一统江湖,全球最热门的10款CPU推荐!

- 电脑的CPU 都有哪些品牌,你知道几个? - 了解电脑CPU的常见品牌

- 如何正确更新NVIDIA显卡驱动以提升性能和稳定性:详细教程

- 微软游戏业务负责人:未来还会继续推出Xbox游戏机,打造更多优秀游戏体验

- 微软GraphRAG AI提效:改善数据检索,tokens成本降低77%的全面指南

微软资讯推荐

- 1 微软发力!暴雪首次为其他游戏打广告,大秘境难度再次下调

- 2 电脑的CPU 都有哪些品牌,你知道几个? - 了解电脑CPU的常见品牌

- 3 如何正确更新NVIDIA显卡驱动以提升性能和稳定性:详细教程

- 4 微软游戏业务负责人:未来还会继续推出Xbox游戏机,打造更多优秀游戏体验

- 5 微软GraphRAG AI提效:改善数据检索,tokens成本降低77%的全面指南

- 6 英伟达AI大模型被曝不及预期,国产GPU能否平替?

- 7 如何查看电脑的显卡型号和性能信息?快速了解电脑显卡配置方法

- 8 微软推送Win10服务器端更新,Win11 24H2升级推荐速度快

- 9 如何正确更新NVIDIA显卡驱动以提升性能和稳定性?

- 10 台式电脑CPU天梯图2024年11月新版 桌面CPU性能排行榜:最新CPU性能排名

win10系统推荐

系统教程推荐